Produkująca znaną wodę mineralną firma Perrier musiała zniszczyć 2 mln butelek towaru. Nakazały to francuskie władze, po tym jak stwierdzono skażenie jednego ze źródeł.Setki palet do utylizacjiSkażenie wykryto w jednej ze studni,…

Andrzej Duda ułaskawił dwóch byłych funkcjonariuszy Centralnego Biura Antykorupcyjnego. Grzegorz P. i Krzysztof B. zostali skazani wspólnie z Mariuszem Kamińskim i Maciejem Wąsikiem w sprawie tzw. afery gruntowej. Mieli odbyć karę jednego roku pozbawienia…

Wybuch elektrowni w Czarnobylu to efekt kilku czynników, jednak bezpośrednią przyczyną były błędy konstrukcyjne reaktora. W nocy z 25 na 26 kwietnia pracownicy przeprowadzili zaległy test systemów bezpieczeństwa nowego, czwartego reaktora. Ten miał wykazać, jak długo w sytuacji awaryjnej, energia kinetyczna…

Mykoła Solski, minister polityki agrarnej Ukrainy w piątek 26 kwietnia został aresztowany. Nakaz jego zatrzymania wydał Wysoki Sąd Antykorupcyjny Ukrainy. Jak przekazuje serwis Ekonomiczna Prawda, sąd przychylił się do czwartkowego wniosku Specjalistycznej Prokuratury Antykorupcyjnej i zastosował wobec Solskiego środek zapobiegawczy…

Kolejne dramatyczne zwroty akcji w sprawie list Prawa i Sprawiedliwości. I znowu sprawa dotyczy Jacka Kurskiego. Były szef TVP stracił jedynkę, ale zyskał miejsce tuż przy prezesie Jarosławie Kaczyńskim. Po środowym bardzo emocjonalnym posiedzeniu klubu PiS i po czwartkowych zwrotach…

Z nieoficjalnych ustaleń mediów wynika, że Daniel Obajtek wystartuje w wyborach do Parlamentu Europejskiego z podkarpackiej listy Prawa i Sprawiedliwości. W rozmowie z dziennikarzem TVN24 do tych doniesień odniósł się minister aktywów państwowych Borys Budka. Borys Budka o starcie Daniela Obajtka – Widocznie ma taką wiedzę, która bezpośrednio obciąża Kaczyńskiego – ocenił decyzję prezesa ugrupowania o zaakceptowaniu kandydatury byłego prezesa Orlenu. Stwierdził,…

Po dwóch kolejkach PGE Ekstraligi Orlen Oil Motor Lublin jest liderem, co nie może być zaskoczeniem. Mistrzowie Polski wygrali najpierw na wyjeździe z ZOOLeszcz GKM Grudziądz (52:38), a potem różnicą 20 punktów pokonali na własnym…

Przed nami długi weekend majowy i coraz więcej cieplejszych dni. W tym okresie modne staje się grillowanie i organizowanie pikników na plażach. Czas relaksu nie rzadko umilają trunki niskoprocentowe. Jeśli planujecie je kupić, warto skorzystać z promocji…

Zapisy nowej doktryny wojskowej przedstawione zostały w trakcie zebrania delegatów Wszechbiałoruskiego Zgromadzenia Ludowego. Jak określono, dokument został zaktualizowany w związku z nowymi wyzwaniami, przed którymi stoi obecnie Białoruś.Jeszcze przed głosowaniem w sprawie zapisów w dokumencie wypowiadał się Alaksandr Łukaszenka, który…

Na – jak zauważył marszałek Szymon Hołownia – 19. wystąpienie z wnioskiem formalnym posła Jarosława Sachajko postanowił odpowiedzieć wiceminister rolnictwa Michał Kołodziejczak. Na mównicy wywiązała się sprzeczka między politykami. Przedstawiciel koła Kukiz’15 cytował słowa Donalda Tuska o niebezpieczeństwie wojny w przypadku…

Ukraińcy nie radzą sobie z rosyjską bronią. Wycofują czołgi i w porozumieniu z USA zmieniają taktykę

W styczniu ubiegłego roku Stany Zjednoczone przekazały Ukrainie 31 czołgów Abrams M1A1. Władze w Kijowie przez wiele miesięcy argumentowały, że pojazdy te będą miały kluczowe znaczenie dla przebiegu wojny z Rosją. Okazało się jednak, że Rosjanie znaleźli sposób na znaczne…

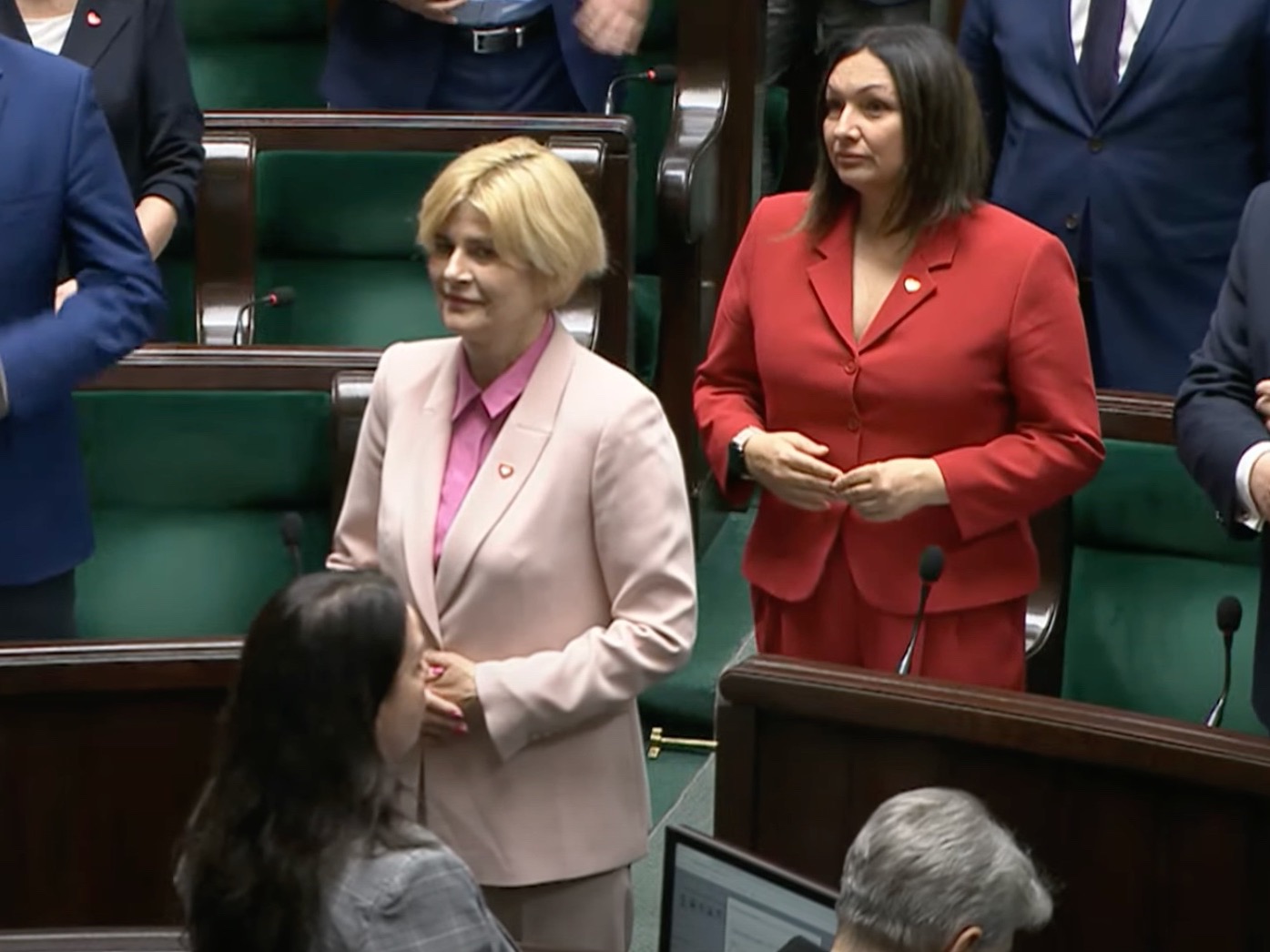

– W związku z wygaśnięciem mandatu pana posła Grzegorza Rusieckiego na podstawie artykułu 251 § 5 Kodeksu wyborczego postanowiłem o wstąpieniu na jego miejsce pani posłanki Alicji Łuczak, która zgłosiła się do ślubowania poselskiego – przekazał w piątek Szymon Hołownia, marszałek Sejmu. Alicja Łuczak zamiast Grzegorza Rusieckiego Rezygnacja Grzegorza…

Biuletyn Polski

Subskrybuj wiadomości i alerty

Otrzymuj najnowsze wiadomości, aktualizacje i wiele innych wiadomości i wskazówek ze Stanów Zjednoczonych bezpośrednio na swoją skrzynkę odbiorczą. Dołącz do naszego biuletynu już teraz, aby być na bieżąco.

Wiadomości z Polski

Zobacz więcejGemini Polska domaga się od Polski odszkodowania za tzw. aptekę dla aptekarza lub uchylenia nowego prawa. Ministerstwo Zdrowia jeszcze w tej sprawie nie odpowiedziało – pisze „Rzeczpospolita”.Czas na polubowne załatwienie sprawy z Warburg Pincus, właścicielem sieci aptek Gemini, Polska ma…

Do wypadku doszło w piątek w godzinach porannych. – Jeden z pojazdów opuścił pas ruchu i doszło do zdarzenia drogowego – przekazał mjr Tomasz Wiktorowicz…

23 kwietna szef MSZ Ukrainy Dmytro Kułeba poinformował o „przywróceniu sprawiedliwego traktowania mężczyzn w wieku mobilizacyjnym”. Placówki konsularne zawiesiły wydawanie paszportów Ukraińcom;Dzień później rząd Ukrainy…

Polityka

Zobacz WięcejWiceminister obrony narodowej Cezary Tomczyk przekazał w czwartek, że współpracownicy byłego szefa MON mieli „nielegalnie pozyskiwać cenne przedmioty, które miały być wręczane ministrom obcych państw”. Na antenie Polsat News opowiedział o szczegółach procederu. Afera zegarkowa w MON – Mówimy tutaj na pewno o kilkudziesięciu przypadkach, wszystkie będą…

Informację o ułaskawieniu dwóch byłych funkcjonariuszy CBA – Grzegorza P. i Krzysztofa B. jako pierwszy przekazał w portalu X dziennikarz Marcin Dobski, zauważając, że na stronie Kancelarii Prezydenta pojawił się…

W czerwcu w krajach Unii Europejskiej odbędą się wybory do Parlamentu Europejskiego. Do urn wyborczych ruszą wszyscy pełnoletni mieszkańcy krajów stowarzyszonych w Unii Europejskiej. Głosować będziemy na wybranych kandydatów z partii…

Biznes

Zobacz Więcej1 lipca 2024 roku miał ruszyć Krajowy System e-Faktur, czyli przeznaczona dla przedsiębiorców platforma do wystawiania i otrzymywania faktur drogą elektroniczną. O tym, że termin nie zostanie dotrzymany, zadecydował na początku roku minister finansów Andrzej Domański. Jego zdaniem system nie był gotowy i zarządził audyt połączony z konsultacjami, w których przedsiębiorcy,…

Marzec przyniósł dalszy spadek inflacji CPI do poziomu 2,0 proc. r/r. Tym samym przedłużona została obecna od lata seria spadkowych odczytów. To pierwsza obserwacja poniżej celu NBP od 5…

Firma doradcza JLL przeanalizowała sprzedaż mieszkań w I kwartale 2024 roku na sześciu głównych rynkach, w Warszawie, Krakowie, Wrocławiu, Trójmieście, Poznaniu i Łodzi. Deweloperzy sprzedali w ciągu trzech miesięcy 11…

Świat

Zobacz WięcejNajnowsze Wiadomości

Zobacz WięcejDo zdarzenia z udziałem brytyjskich pojazdów doszło w czwartek 25 kwietnia około godz. 17.00 w Szczecinie na ul. Szosa Stargardzka przed Płonią – poinformował portal „Kurier Szczeciński”. Pojazdy jechały od Płoni w kierunku Stargardu (DK10). Zobacz wideo Spy Cops –…

Władimir Putin ogłosił podczas czwartkowej konferencji, że w maju planuje podróż do Chin. Zapowiedź potwierdza coraz bliższą relację między Moskwą a Pekinem, która rozwija się od początku rosyjskiej inwazji na Ukrainę w 2022 r.Władimir Putin pojedzie do ChinJak zauważył w mediach…

Wojska Obrony Terytorialnej o śmierci żołnierza przekazały w czwartek w mediach społecznościowych. „Z ogromnym smutkiem i żalem informujemy o śmierci naszego żołnierza z 14. Zachodniopomorskiej Brygady Obrony Terytorialnej, który zmarł dziś z przyczyn naturalnych podczas pełnienia służby na granicy polsko-białoruskiej”…

Chalil Al-Hajja, członek kierownictwa Hamasu, poinformował, że jego organizacja zgodzi się na rozbrojenie i zawarcie minimum pięcioletniego rozejmu z Izraelem, jeżeli zostanie spełniony jeden warunek. Hamas chce, aby Izrael zaakceptował utworzenie niepodległego państwa palestyńskiego w granicach sprzed wojny sześciodniowej z…

Świadomie przyjmowała datki od handlarzy narkotyków i oszustów. Wstawiała się za nimi u amerykańskich prokuratorów i sędziów. Dla Kościoła, który od wieków stał po stronie latyfundystów, panów pańszczyźnianych i kolonizatorów, takie postaci jak Matka Teresa z Kalkuty są użyteczne. Kiedy…

Jakiś czas temu Belinda Bencic poinformowała, że zawiesza swoją karierę tenisową. Nie było to spowodowane żadną kontuzją ani problemami, reprezentantka Szwajcarii zaszła w ciążę. Partnerem mistrzyni olimpijskiej z Tokio 2021 jest były słowacki piłkarz Martin Hromkovic. „Oczekujemy naszego małego cudu! Już nie możemy się doczekać, aby Cię…

Przy Piazzale Roma, przy wjeździe do Wenecji, odbył się protest przeciwko nowej opłacie wymaganej od jednodniowych turystów. Według organizatorów zgromadziło się ponad tysiąc osób, ale policja uważa, że było ich tylko 300. Protest przeciwko nowej opłacie w WenecjiDrugi mniejszy protest odbył się…

Wybory do Parlamentu Europejskiego odbędą się 9 czerwca 2024 roku. W pozostałych krajach Unii Europejskiej będą mieć one miejsce w różnych terminach – od 6 do 9 czerwca.Wybory do Parlamentu Europejskiego 2024. Czym jest Parlament Europejski?Parlament Europejski jest instytucją Unii Europejskiej, która…

Jaros³aw Kaczyñski był gościem czwartkowego (25 kwietnia) odcinka „Magazynu Anity Gargas”. Na samym początku prowadząca programu zapytała prezesa PiS, czy mimo intensywnej kariery politycznej ma nadal czas na swoje hobby. – Teraz tego czasu jest bardzo mało na hobby. Ale jeśli za…

Pięć minut wystarczy, by ukraść samochód. Wyczyszczenie mieszkania zajmuje włamywaczom od dwóch do dziesięciu minut. Zwiększa się też liczba tzw. „szybkich akcji”. — Odżywają stare metody, których w Polsce nie było przez ostatnich 20 lat —mówi specjalista od zabezpieczeń. —…

Najbardziej popularny

Minister obrony narodowej Władysław Kosiniak-Kamysz powiedział w czwartek 25 kwietnia, że Polska jest gotowa pomagać Ukrainie w kwestii mobilizacji. Wicepremier podkreślił swoją solidarność z Ukraińcami walczącymi na froncie i dodał,…

Jak rozróżnić euforię od złości, a zakochanie od emocji związanych z porzuceniem? Umysł ma skłonność do zwodzenia samego siebie. W wielu sytuacjach mylnie rozpoznaje własne stany. To mało budującą wiadomość.…

Kwestia diagnostyki precyzyjnej w leczeniu nowotworów była poruszona na panelu otwarcia konferencji Wizjonerzy Zdrowia. Eksperci podkreślali, że mamy obecnie wiele refundowanych nowych terapii, jednak często pacjenci nie mogą ich dostać przez to, że nie mają…

Iga Świątek nazywana jest królową mączki. Nie bez przyczyny, w końcu trzykrotnie wygrała Rolanda Garrosa. Ponadto raszynianka wielokrotnie triumfowała w największych turniejach na tej nawierzchni. Pierwsza rakieta świata jest dwukrotną mistrzynią Internazionali BNL d’Italia…

Jak poinformowała policja stanowa, dużych rozmiarów gad, który również stracił życie podczas wypadku, na krótko przed zderzeniem z pojazdem opuścił pobliskie zarośla i pojawił się nagle na jezdni. Autem jechała…

Na czele najnowszego rankingu zaufania IBRiS dla Onetu znalazł się premier Donald Tusk z wynikiem na poziomie 45 proc. To wzrost o 5,8 punktu procentowego w porównaniu do poprzedniego badania (szef rządu zajmował wówczas czwartą lokatę). Jednocześnie Tuskowi nie ufa 49 proc. badanych. Na…